Page 65 - 2023年第54卷第7期

P. 65

WRERJE学习到更多样的特征。

( 2)随机插入。基于随机插入的数据增强方式本质是在规整的数据集中加入一定的噪声。首先定

位语句中的一个词,然后将这个词的同义词插入到语句中的随机位置。此方法可获取更多描述模糊但

实体和关系均正确标注的语句,学习此类语句可使 WRERJE拥有从模棱两可的句子中准确识别出水利

工程抢险实体和关系的能力。

将 1652条有效标注样本,以 7∶3的比例划分,得到 1159条语句作为初始训练集,493条语句作

为初始测试集。将以上文本数据增强策略分别应用于初始训练集和初始测试集,两种数据集分别进行

增强以确保突变前后的语句在同 一类 数据 集中,防止发 生数 据泄 露 [34] 。经 过增 强策 略后 得 到包含

3471条语句的最终训练集和包含 1485条语句的最终测试集。最终训练集用于微调 T5,最终测试集用

于测试微调后 T5的性能。此外,从最终训练集中选择包含实体且实体间具有语义关系的 2953条语句

作为分类器训练集,从最终测试集中选择包含实体且实体间具有语义关系的 1265条语句作为分类器

测试集。

3.3.3 基于 Bert的分类器训练 将 Schema中定义的 6种关系建为语句上的 6个离散标签,基于 Bert

的分类器进行句子级预分类,得到每个输入语句最可能的 N种关系类型,动态提示生成器根据 N种关

系类型生成相应的动态提示序列。

分类器由 Bert结合线形层组成。存在 6种关系类型,线性层的输出维度设置为 6。使用分类器训

练集对分类器进行训练。将语句作为 Bert的输入,从 CLS字段中获得隐藏向量 V ,从 CLS中获取的

L

隐藏向量 V 相比其他位置能更好的表征句子特征,从而获得更好的分类性能。然后将 V 输送到线性

L

L

层中,该线性层生成 6维向量,每个维度各对应一个关系类型。在反向传播中,使用交叉熵损失调整

Bert与线性层参数。损失函数为:

r - 1

(

(

L( μ ,r) =-μ [r] + log ∑ expμ [i] ) ) (7)

i =0

)表示线性层的输出结果,r为句子的真实标签。

式中 μ = ( μ 0 ,μ 1 ,…,μ r - 1

3.3.4 基于 T5的联合抽取器微调 WRERJE框架的设计思想是将抽取任务视为序列到序列的生成任

务,生成式语言模型 T5被证实具有捕获丰富语义信息的能力 [35] ,并且在各种下游 NLP任务中表现出

了良好的性能。本文的抽取器基于大型预训练语言模型 T5(T5 - v1.1 - large)实现。

为了微调 T5,将最终训练集中的每个句子转换为 SEL序列,将其输入动态提示生成器以获取动态

- 4

提示序列 I,最后构建带标签的语料库:D = {(I,y)},在带标签的语料库上,使用学习率为 10 的

e

Adam优化器和教师强制(teacher - forcing)交叉熵损失,损失函数为:

FT ∑

L = - logP(yI;θ e ,θ d ) (8)

(I,y) ∈D e

分别为编码器和解码器参数。

式中 θ e 、θ d

4 实验设置

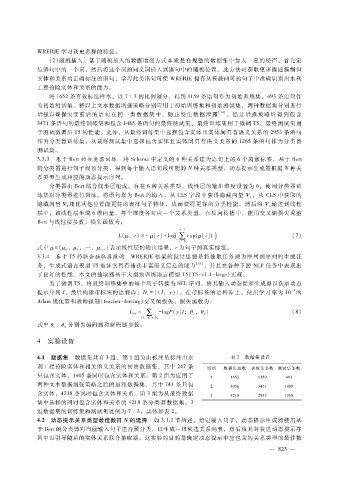

4.1 数据集 数据集共有 3组,第 1组为由标注员标注出水 表 2 数据集设置

利工程抢险实体和相关语义关系的初始数据集,其中 247条 组别 数据集总数 训练集条数 测试集条数

只包含实体,1405条同时包含实体和关系。第 2组为应用了

1 1652 1159 493

两种文本数据增强策略之后的最终数据集,其中 741条只包

2 4956 3471 1485

含实体,4218条同时包含实体和关系。第 3组为从最终数据 3 4218 2953 1265

集中选择的同时包含实体和关系的 4218条分类器数据集。3

组数据集的训练集和测试集比例为 7∶3,具体如表 2。

4.2 动态提示关系类型最佳数目 N的选择 如 3.1.2节所述,给定输入句子,动态提示生成器使用基

于 Bert的分类器对当前输入句子进行预分类,以生成一组候选关系列表,然后将其封装进动态提示序

列中以引导随后的实体关系联合抽取器。此实验的目的是确定动态提示中应包含的关系类型的最佳数

— 8 2 3 —