Page 139 - 2025年第56卷第1期

P. 139

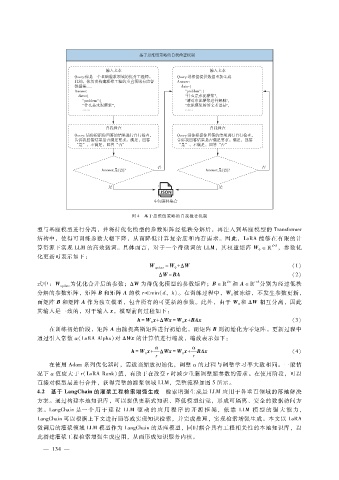

图 4 基于思维链策略的自我检查机制

型与基座模型进行分离,并将待优化模型的参数矩阵经低秩分解后,再注入到基座模型的 Transformer

结构中,使得可训练参数大幅下降,从而降低计算复杂度和内存需求。因此,LoRA能够在有限的计

算资源下实现 LLM的高效微调。具体而言,对于一个待微调的 LLM,其权重矩阵 W ∈! d × k ,参数优

0

化更新可表示如下:

W update = W + Δ W (1)

0

Δ W= BA (2)

式中:W 为优化合并后的参数;Δ W 为待优化模型的参数矩阵;B ∈! d × r 和 A ∈! r × k 分别为经过低秩

update

分解的参数矩阵,矩阵 B和矩阵 A的秩 r min(d,k)。在训练过程中,W 被冻结,不发生参数更新,

0

而矩阵 B和矩阵 A作为独立模型,包含所有的可更新的参数。此外,由于 W 和 Δ W 相互分离,因此

0

其输入是一致的,对于输入 x,模型前向过程如下:

h = W x + Δ Wx = W x + BAx (3)

0 0

在训练初始阶段,矩阵 A由随机高斯矩阵进行初始化,而矩阵 B则初始化为零矩阵。更新过程中

通过引入常数 α (LoRAAlpha)对 Δ Wx的计算值进行缩放,缩放表示如下:

α α

h = W x + Δ Wx = W x + BAx (4)

0 0

r r

在使用 Adam系列优化器时,需适当缩放初始化,调整 α的过程与调整学习率大致相同。一般情

况下 α值应大于 r(LoRARank)值,有助于在改变 r时减少重新调整超参数的需求。在使用阶段,可以

直接对模型层进行合并,获得完整的灌浆领域 LLM,完整流程如图 5所示。

4.2 基于 LangChain的灌浆工程检索增强生成 检索增强生成是 LLM应用于各垂直领域的落地解决

方案。通过构建本地知识库,可以提供更新式知识、降低模型幻觉,形成可隔离、安全的数据访问方

案。LangChain是一 个 用 于 建 设 LLM 驱 动 的 应 用 程 序 的 开 源 框 架, 依 靠 LLM 模 型 的 强 大 能 力,

LangChain可以根据上下文进行回答或实现知识检索,并完成推理,实现检索增强生成。本文以 LoRA

微调后的灌浆领域 LLM模型作为 LangChain的基座模型,同时耦合具有工程相关性的本地知识库,以

此搭建灌浆工程检索增强生成应用,从而形成知识服务内核。

— 1 3 —

4