Page 141 - 2025年第56卷第1期

P. 141

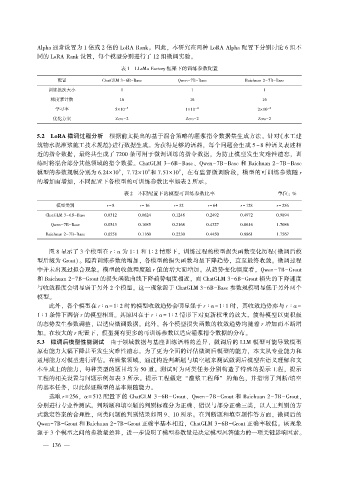

Alpha 通常设置为 1 倍或 2 倍的 LoRA Rank。 因此, 本研究在两种 LoRA Alpha 配置下分别讨论 6 组不

同的 LoRA Rank 设置, 每个模型分别进行了 12 组微调实验。

表 1 LLaMa Factory 框架下的训练参数配置

配置 ChatGLM 3-6B-Base Qwen-7B-Base Baichuan 2-7B-Base

训练批次大小 1 1 1

梯度累计数 16 16 16

学习率 5×10 -5 1×10 -4 2×10 -4

优化方案 Zero-2 Zero-2 Zero-2

5.2 LoRA 微调过程分析 根据前文提出的基于混合策略的灌浆指令数据集生成方法, 针对《水工建

筑物水泥灌浆施工技术规范》进行数据生成。 为获得足够的语料, 每个问题会生成 5 ~ 8 种语义表述相

近的指令数据, 最终共生成了 7200 条可用于微调训练的指令数据, 为防止模型发生灾难性遗忘, 训

练时将混合部分其他领域的指令数据。 ChatGLM 3-6B-Base、 Qwen-7B-Base 和 Baichuan 2-7B-Base

9

9

模型的参数规模分别为 6.24×10 , 7.72×10 和 7.51×10 , 在有监督微调阶段, 模型的可训练参数随 r

9

的增加而增加, 不同配置下各模型的可训练参数比率如表 2 所示。

表 2 不同配置下的模型可训练参数比率 单位: %

模型类别 r = 8 r = 16 r = 32 r = 64 r = 128 r = 256

ChatGLM 3-6B-Base 0.0312 0.0624 0.1248 0.2492 0.4972 0.9894

Qwen-7B-Base 0.0543 0.1085 0.2168 0.4327 0.8616 1.7086

Baichuan 2-7B-Base 0.0558 0.1160 0.2230 0.4450 0.8861 1.7567

图 8 显示了 3 个模型在 r ∶ α 为 1∶ 1 和 1∶ 2 情形下, 训练过程的模型损失函数变化历程(微调后模

型后缀为 Grout)。 随着训练步数的增加, 各模型的损失函数均呈下降趋势, 直至最终收敛。 微调过程

中并未出现过拟合现象。 模型的收敛程度随 r 值的增大而增加。 从趋势变化幅度看, Qwen-7B-Grout

和 Baichuan 2-7B-Grout 的损失函数曲线下降趋势幅度相近, 而 ChatGLM 3-6B-Grout 损失的下降速度

与收敛程度会明显弱于另外 2 个模型。 这一现象源于 ChatGLM 3-6B-Base 参数规模明显低于另外两个

模型。

此外, 各个模型在 r ∶ α = 1∶ 2 时的模型收敛趋势会明显强于 r ∶ α = 1∶ 1 时, 其收敛趋势亦与 r ∶ α =

1 ∶ 1 条件下两倍 r 的模型相当。 其原因在于 r ∶ α = 1 ∶ 2 情形下对更新权重的放大, 使得模型以更积极

的态势发生参数调整, 以适应微调数据。 此外, 各个模型损失函数的收敛趋势均随着 r 增加而不断增

加。 在较大的 r 配置下, 模型拥有更多的可训练参数以适应灌浆指令数据的分布。

5.3 微调后模型性能测试 由于领域数据与基座训练语料的差异, 微调后的 LLM 模型可能导致模型

原有能力大幅下降甚至发生灾难性遗忘。 为了更为全面的评估微调后模型的能力, 本文从专业能力和

通用能力对模型进行评估。 在灌浆领域, 通过构造判断题与填空题来测试微调后模型在语义理解和文

本生成上的能力, 每种类型的题目均为 50 道。 测试时为两类任务分别构造了特殊的提示工程, 提示

工程的相关设置与问题示例如表 3 所示。 提示工程假定 “灌浆工程师” 的角色, 并指明了判断∕填空

的基本任务, 以此保证模型的基本跟随能力。

选取 r = 256, α = 512 配置下的 ChatGLM 3-6B-Grout、 Qwen-7B-Grout 和 Baichuan 2-7B-Grout,

分别进行专业性测试。 判断题和填空题的判别标准分为正确、 错误与部分正确三类, 以人工判别的方

式裁定答案的合理性, 两类问题的判别结果如图 9、 10 所示。 在判断题和填空题作答方面, 微调后的

Qwen-7B-Grout 和 Baichuan 2-7B-Grout 正确率基本相近, ChatGLM 3-6B-Grout 正确率较低。 该现象

源于 3 个模型之间的参数量差异, 进一步说明了模型参数量是决定模型回答能力的一项关键影响因素。

— 1 3 6 —