Page 66 - 水利学报2025年第56卷第3期

P. 66

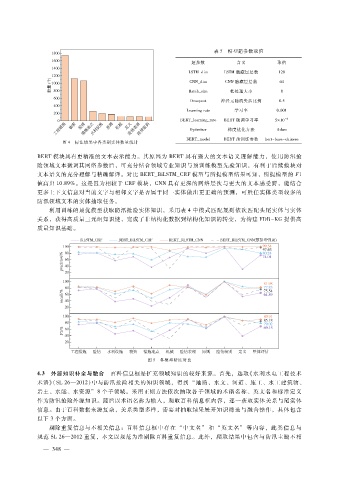

表 5 模型超参数取值

超参数 含义 取值

LSTM_dim LSTM隐藏层层数 128

CNN_dim CNN隐藏层层数 64

Batch_size 批处理大小 8

Droupout 神经元随机失活比例 0.5

Learningrate 学习率 0.001

BERT_learning_rate BERT微调学习率 5 × 10 - 6

Optimizer 梯度优化方法 Adam

BERT_model BERT预训练参数 bert - base - chinese

图 4 标注结果中各类别实体数量统计

BERT模块具有更精准的文本表示能力。其原因为 BERT具有强大的文本语义理解能力,使用防汛抢

险领域文本微调其网络参数后,可充分结合领域专业知识与预训练模型先验知识,有利于后续模块对

文本语义的充分理解与精确解译。对比 BERT_BiLSTM_CRF模型与所提模型结果可知,所提模型的 F1

值高出 10.89%。这是因为相较于 CRF模块,CNN具有更深的网络层次与更大的文本感受野,能结合

更多上下文信息对当前文字与相邻文字是否属于同一实体做出更正确的预测,可胜任实体类型较多的

防汛领域文本的实体抽取任务。

利用训练的最优模型获取防汛抢险实体知识,采用表 4中模式匹配规则依次匹配头尾实体与实体

关系,获得高质量三元组知识链,完成了非结构化数据到结构化知识的转变,为构建 FDR - KG提供高

质量知识基础。

图 5 各模型精度对比

4.3 外源知识补全与融合 百科信息框是扩充领域知识的较好来源。首先,选取《水利水电工程技术

术语》( SL26—2012)中与防汛抢险相关的知识领域,得到 “地质、水文、河道、施工、水工建筑物、

岩土、水能、水资源”8个子领域。采用正则方法依次抽取各子领域的术语名称、英文名和标准定义

作为防汛抢险外源知识。随后以术语名称为输入,爬取百科信息框内容,逐一获取实体关系与尾实体

信息。由于百科数据来源复杂,关系类型多样,需要对抽取结果展开知识筛选与融合操作,具体包含

以下 3个方面。

剔除重复信息与不相关信息:百科信息框中存在 “中文名” 和 “英文名” 等内容,此类信息与

规范 SL26—2012重复,本文以规范为准剔除百科重复信息。此外,爬取结果中包含与防汛主题不相

— 3 4 —

8